Il y a quatre ans, j’ai écrit un article intitulé “De PHP 7 à PHP 8, retour sur cinq ans d’innovation”. Alors que PHP 8.5 va sortir à la fin de l’année, et que les deux dernières versions d’Ubuntu (la 25.04 et la 25.10) intègrent PHP 8.4, c’est le bon…

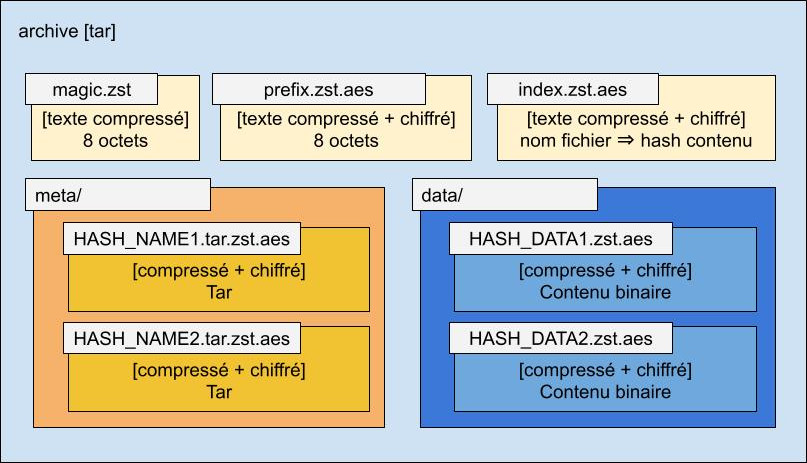

Créer un format d’archivage dédupliqué, chiffré et compressé, compatible avec les outils Unix standards

Introduction Depuis 2017, je gère le projet Arkiv, qui permet de sauvegarder des serveurs facilement. Il sauvegarde les fichiers/répertoires et les bases de données MySQL (avec mysqldump ou XtraBackup), avec un archivage sur Amazon S3 et Amazon Glacier. C’est un script shell assez complexe (près de 1200 lignes de code).…

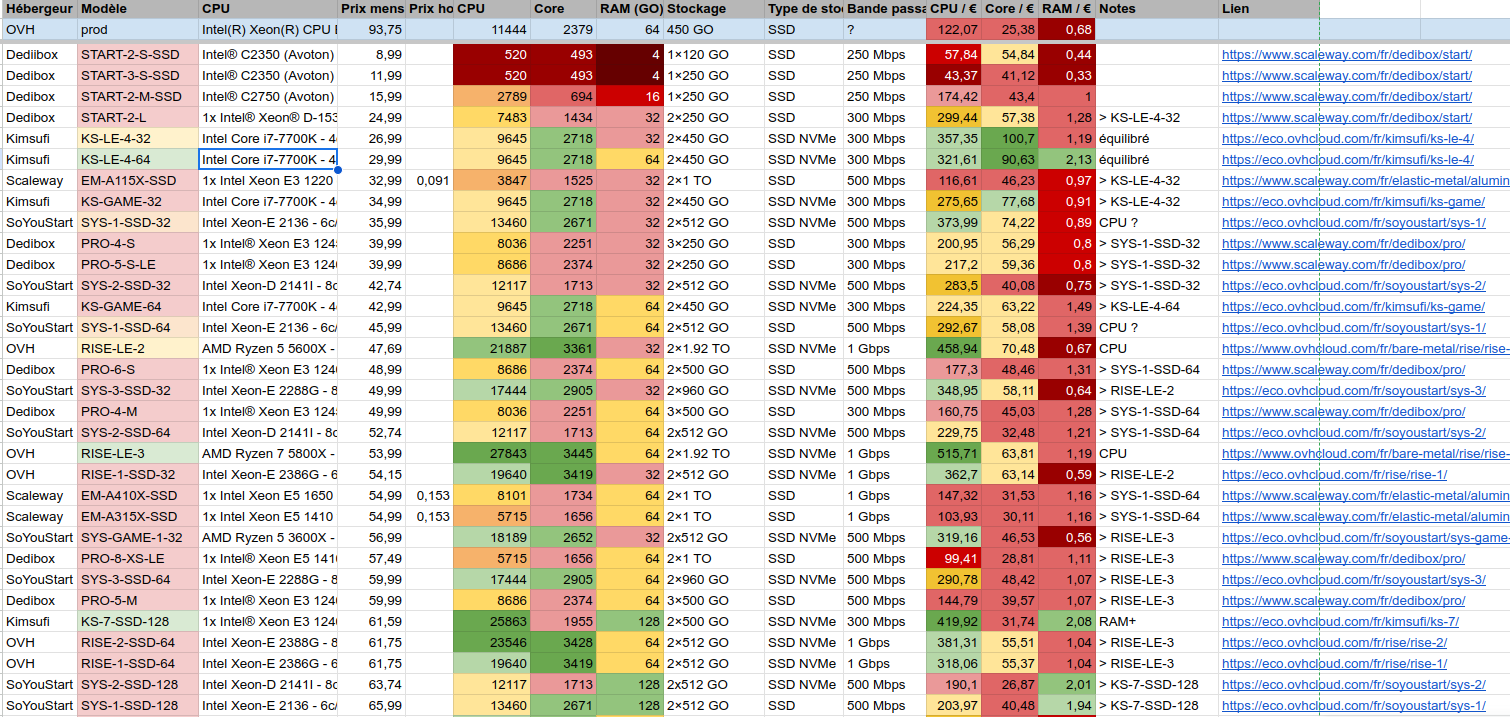

Un site pour comparer en temps réel les offres de serveurs dédiés OVH et Dedibox

Dans un précédent article, j’ai partagé un tableau Google Sheet dans lequel je répertoriais les offres de serveurs dédiés proposées par OVH (sous les marques OVHCloud, SoYouStart et Kimsufi) et Scaleway (avec les offres Dedibox et Elastic Metal). J’espère que ce tableau a été utile à certains. Il l’a été…

Le Manifeste PHP Way of Life

Ça fait longtemps maintenant que je prône une vision du développement PHP qui utilise les bonnes pratiques de manière intelligente et mesurée, et qui repose sur quelques fondamentaux forts : À force d’expliquer mon point de vue oralement, il m’a paru plus efficace de le mettre par écrit. Je l’ai…

Comparatif des offres de serveurs dédiés OVH et Scaleway

Mise à jour : J’ai créé le site ServerTracker.ovh pour lister les offres OVH et Dedibox, avec les informations de disponibilité en temps réel. Plus d’infos dans cet article. Pour des besoins professionnels, j’ai créé un tableau qui liste les offres de serveurs dédiés chez OVH et Scaleway. Le but…

Créer une partition chiffrée sous Linux avec LUKS

En entreprise, il y a souvent des cas où on veut protéger des données sensibles. Le plus souvent, on archive les données dans des fichiers cryptés ; en cas de besoin, on peut décrypter ces archives pour y accéder, et en attendant on est rassuré sur le fait que personne…

Comment calculer la complexité d’un mot de passe et comment choisir un mot de passe

L’imaginaire collectif nous implante l’idée qu’un mot de passe doit être long (composé de beaucoup de caractères) et complexe (composé de beaucoup de caractères différents) pour être de bonne qualité. On va essayer de voir ce que ça représente exactement. Quelles sont les attaques sur les mots de passe ?…

Crypter un fichier sous Linux avec OpenSSL, GPG ou scrypt

Sous Linux, nous avons la chance d’avoir plusieurs outils qui peuvent être utilisés pour crypter des fichiers. Nous allons voir comment le faire avec les outils suivants : Il y a un principe que je vais appliquer dans les trois cas : la passphrase (le mot de passe) d’encryption ne…

Plus ça change, plus c’est pareil. L’éternel recommencement, de la voiture électrique au développement web

Première anecdote Je suis tombé sur un article très intéressant sur le blog officiel de Google. Il y est fait référence à un article du journal Electrical World, qui dit en substance : « Les raisons fondamentales pour lesquelles la voiture électrique n’a pas atteint la popularité qu’elle mérite sont (1) l’échec…

Enregistrer le terminal en vidéo avec asciinema

Il peut arriver qu’on ait besoin de partager une vidéo servant à montrer ce qu’on voit dans son terminal. Personnellement, j’ai eu besoin notamment pour illustrer de la documentation. Plus récemment, avec mon équipe nous avons fait un exercice de programmation dont le but était d’implémenter le jeu de la…